主讲人:李子豪

英国格拉斯哥大学法学院讲师(长聘助理教授)、博士生导师

时间2023年11月11日,博士联盟(Doctorate Association)2023年第5期线上沙龙「ChatGPT,大语言模型与人工智能治理——机遇与挑战」圆满落幕。

活动分享内容

(1)LLMs大语言模型简介;

(2)AI「模仿」和「幻象」涉及的法律和伦理问题;

(3)准确性悖论;

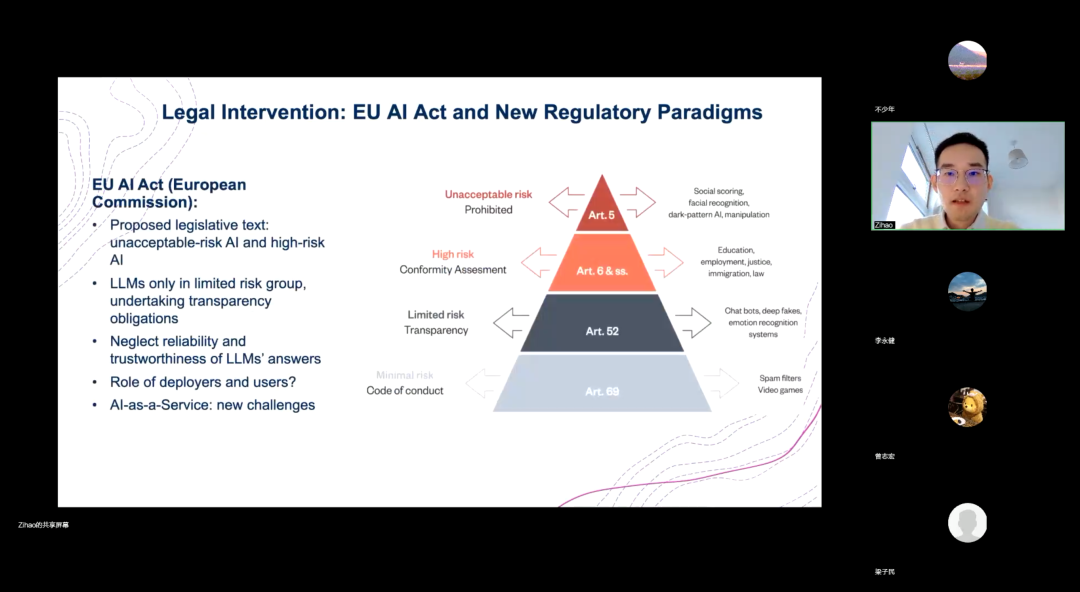

(4)欧盟AI法案和新的监管范式;

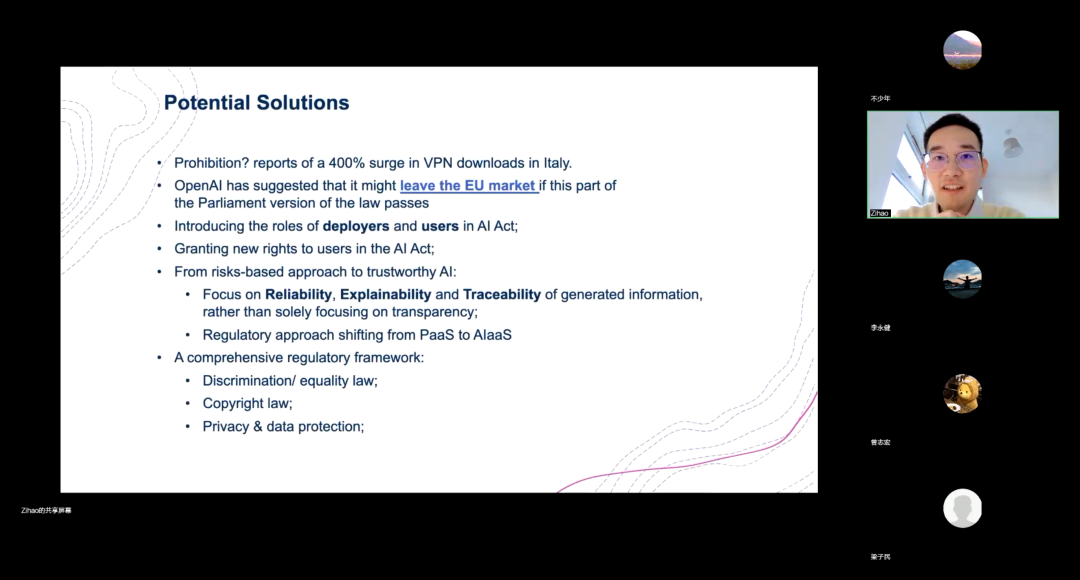

(5)AI监管的潜在解决方案和展望;

主讲者李子豪老师,英国格拉斯哥大学法学院讲师(长聘助理教授)、博士生导师,英国CREATe研究中心研究员,美国斯坦福大学特聘研究员,爱尔兰都柏林圣三一大学客座讲师。拥有法学、计算机专业双学位,荣获英国伦敦政治经济学院(LSE)现代法律评论奖,并被中国教育部评为2022年度优秀海外中国学者。参与英国、欧盟多项研究项目,成果发表于Nature、Computer Law and Security Review、IEEE Communication Magazine等多个SCI/SSCI一区、EI国际顶级期刊,受邀在剑桥大学、伦敦大学国王学院发表专题演讲,接受央视外语频道(CGTN)专访。

本期讲座视频

本讲座基于近期于李子豪老师《Nature Machine Intelligence》上发表的新研究《Why the European AI Act transparency obligation is insufficient》。

LLMs大语言模型简介

主讲人李子豪老师介绍了LLMs大语言模型的基本定义,以及机器学习训练模型的方式, 包括监督学习,无监督学习,和通过人类反馈进行的强化学习(Reinforcement Learning from Human Feedback, RLHF)。此外,主讲人认为,LLMs使用机器学习预测序列中下一个特定单词出现的概率,而并非真正理解语言。

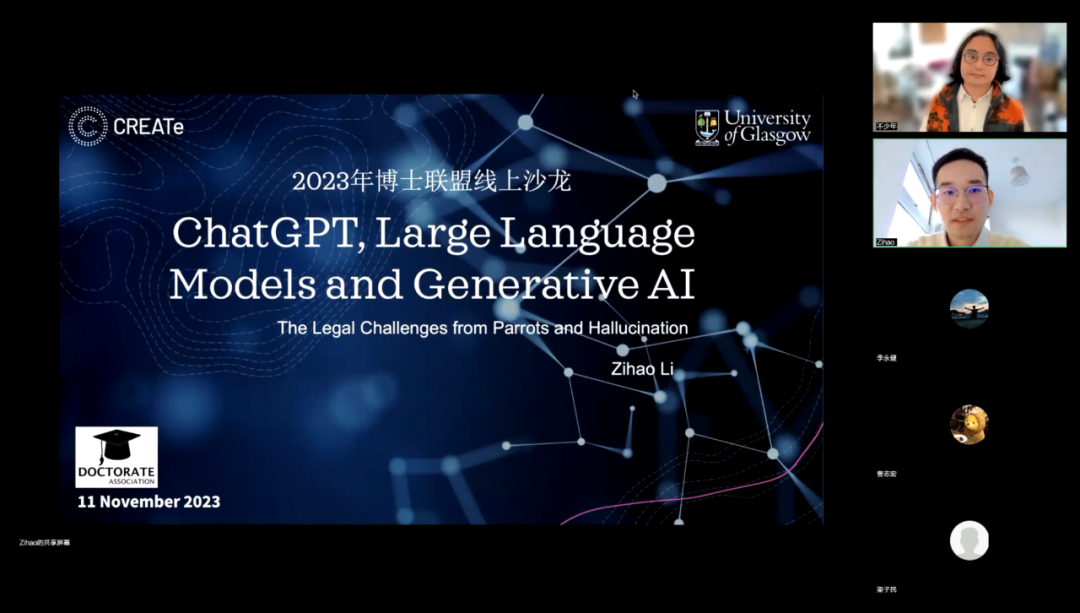

AI「模仿」和「幻象」涉及的法律和伦理问题

主讲人详细介绍了生成式AI的「模仿」(Parroting)和「幻象」(Hallucination)问题,并解释了这两个问题可能引发的潜在风险。譬如,由于AI是通过学习人类提供的语料库进行训练的,因此其生成的内容不可避免地会「模仿」人类社会既有的偏见和歧视,从而强化对某些人群的刻板印象。此外,AI还可能引发「幻象」问题,例如制造不准确和误导性的信息,在医疗诊断方面可能造成人身伤害,或者创作虚假新闻传播仇恨。在讲座中,李子豪老师介绍了更多具体的法律和伦理问题,如侵犯版权,决策失误等,可以点击视频了解详情。

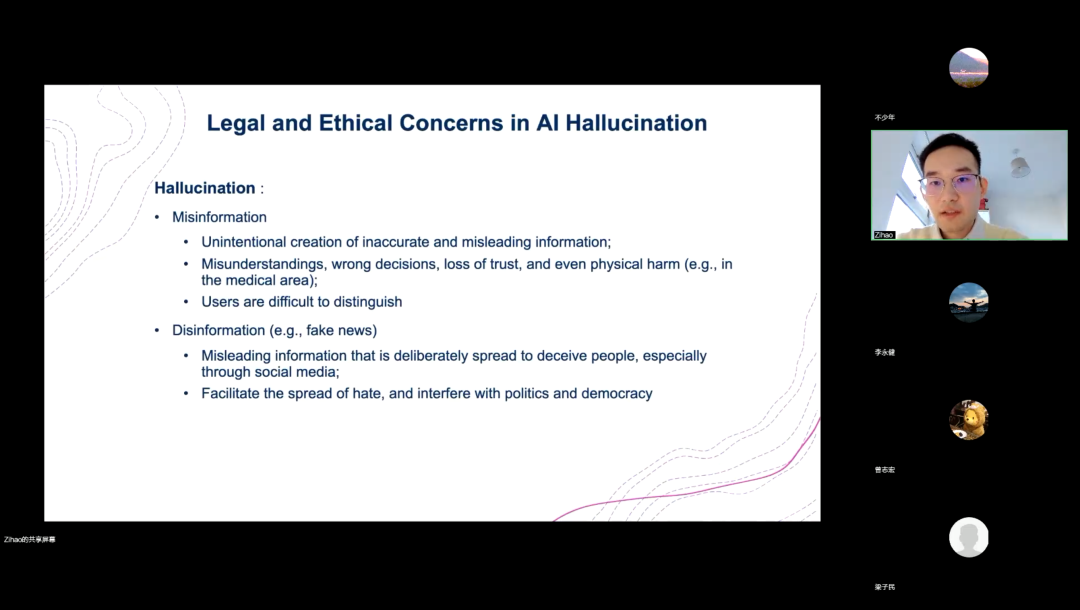

准确性悖论

李子豪老师提出了一个概念:准确性悖论(Accuracy Paradox)。即,仅通过引入新数据和算法来提高模型的准确性是不够的。这是因为随着模型的准确性增加,用户就更可能会过度依赖它,从而不再验证模型的输出。但是,LLMs只是预测单词出现的可能性,而不是真正理解材料内容。因此,即使模型非常准确,也无法提供100%可信赖的答案。李子豪老师指出,在医疗或法律这类专业领域,即便只有0.1%或0.2%的答案是错误的,也会给用户辨别其真实性带来巨大难度。

欧盟AI法案和新的监管范式

主讲人肯定了欧盟AI法案的价值,同时也指出了其中的不足。在详细介绍欧盟法案对AI的定义以及采用的4级风险分类方式时,李子豪老师提出欧盟法案忽视了大语言模型所提供的回答的可靠性(reliability and trustworthiness),同时缺乏对AI部署者与用户的规范。主讲人强调,由于大语言模型新近才被广泛应用,相关监管必然面对各类新动态的风险和挑战。

AI监管的潜在解决方案和展望

李子豪老师通过意大利官方封禁Open-AI引发的戏剧性结果说明,旧有监管方式很难起到作用。李子豪老师提出了综合监管的解决方案,认为对大语言模型的监管应当建立一套完整的体系,而非依赖单一的法律或规范。譬如,在AI法案中赋予用户新权利;重点关注生成信息的可靠性、可解释性和可追溯性,而不仅仅是透明度;监管方法从PaaS转向AIaaS;健全歧视/平等法律和版权法等。

讲座结束后,来自曼切斯特大学计算机系博士毛胜忠、伯明翰大学计算机系博士梁子民、李永健、UCL机械工程系的博士梁策和来自UCL历史系的博士李赛林等听众先后提问,与主讲人交流,从国内外AI相关法规出台的先后顺序,各国出台的AI法案之间的差异和共性,AI大模型对下一个十年的社会发展的影响,AI大模型提高社会生产力、增加社会财富、提升国民经济等话题展开了广泛的讨论,一度将学术沙龙再次推向高潮。

视频链接:

https://www.bilibili.com/video/BV1nQ4y1x7fd/